3 FAÇONS DONT L’IA POURRAIT MENACER NOTRE MONDE, ET CE QUE NOUS DEVONS FAIRE POUR RESTER EN SÉCURITÉ

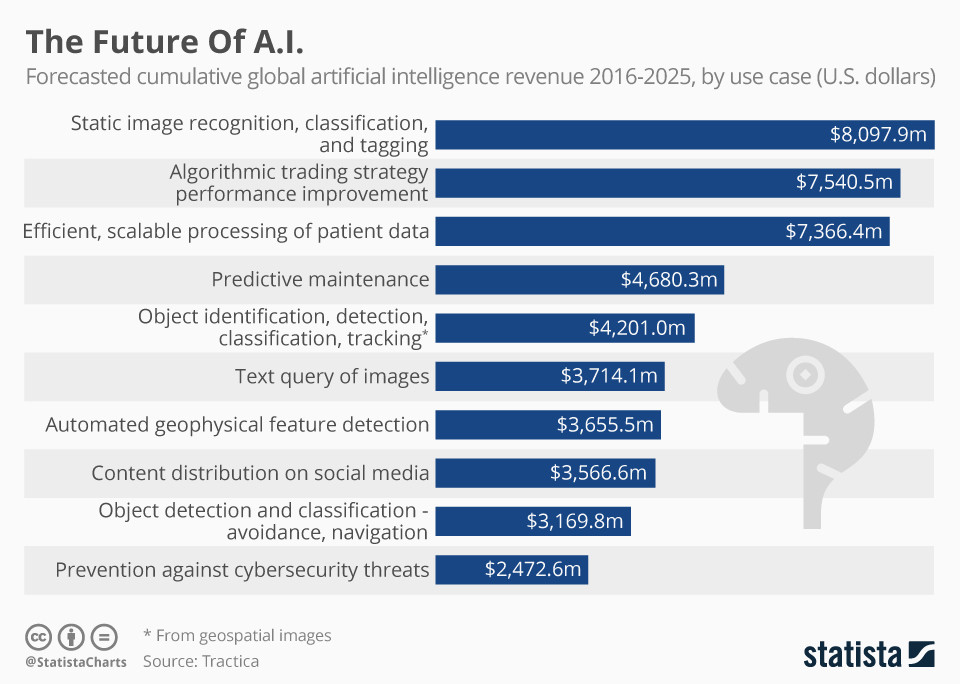

L’intelligence artificielle (IA) pourrait améliorer considérablement nos vies et avoir un impact positif sur tout, des soins de santé à la sécurité, en passant par la gouvernance et l’économie. Mais presque toutes les technologies peuvent être utilisées aussi bien à bon qu’à mauvais escient.

Le rapport sur l’utilisation malveillante de l’intelligence artificielle, compilé par des experts d’un certain nombre d’institutions, dont l’Université de Cambridge et la société de recherche OpenAI, soutient qu’entre de mauvaises mains, l’intelligence artificielle pourrait être exploitée par des États voyous, des terroristes et des criminels.

Le rapport décrit trois domaines – physique, numérique et politique – où l’IA est le plus susceptible d’être exploitée, et décrit des scénarios sur la façon dont les attaques d’IA pourraient se dérouler.

1. Accidents de voiture télécommandés

La plus grande préoccupation concerne l’utilisation de l’IA pour perpétrer des attaques physiques contre les humains, comme le piratage de voitures auto-portées pour causer des collisions majeures.

« Si plusieurs robots sont contrôlés par un seul système d’IA exécuté sur un serveur centralisé, ou si plusieurs robots sont contrôlés par des systèmes d’IA identiques et présentés avec les mêmes stimuli, alors une seule attaque pourrait également produire des défaillances simultanées sur une échelle par ailleurs peu plausible », indique le rapport.

Peter Stone, professeur à l’Université du Texas Austin, qui fait partie d’une équipe qui a récemment mis au point un nouvel algorithme pour améliorer la façon dont les robots et les humains communiquent, pense que les avertissements du rapport devraient être pris au sérieux, mais que la situation n’est pas nouvelle ou unique aux véhicules autonomes.

« Si quelqu’un aujourd’hui devait changer tous les feux de circulation d’une ville pour qu’ils soient simultanément verts, une catastrophe s’ensuivrait “, nous dit le Dr Stone. “Et le fait que notre réseau électrique soit assez centralisé nous rend vulnérables aux pannes de courant à grande échelle. »

Selon M. Stone, la réponse appropriée serait de renforcer les mesures de sécurité, ainsi que la redondance – la fourniture d’une capacité de secours – et la décentralisation de la prise de décision.

2. Phishing sophistiqué

À l’avenir, les tentatives d’accès à des renseignements personnels et de nature délicate de la part d’une personne pourraient être effectuées presque entièrement par AI.

« Ces attaques peuvent utiliser les systèmes d’IA pour accomplir certaines tâches avec plus de succès que n’importe quel humain », dit le rapport, ajoutant que la fraude ou le vol d’identité pourrait devenir plus raffiné et plus efficace au fur et à mesure que l’IA évolue.

Si la plupart des recherches et des messages typiques d’une escroquerie par hameçonnage pouvaient être traités par l’IA, un plus grand nombre de personnes seraient dupés par cette activité.

L’IA pourrait se faire passer pour les vrais contacts des gens, en utilisant un style d’écriture qui imite le style de ces contacts, ce qui rend plus difficile le repérerage de l’escroquerie.

Le professeur de robotique à l’Université Carnegie Mellon Illah Nourbakhsh dit que puisque l’IA évolue rapidement, nous avons besoin de réponses plus rapides pour faire face à ses risques. « Le vrai défi est d’envisager des mesures politiques pour maximiser le bien et minimiser le mal « , dit Nourbakhsh. Tout comme les escrocs humains trouvent des moyens de plus en plus sophistiqués et nuancés pour soutirer de l’argent aux gens à l’aide d’escroqueries en ligne, les acteurs malveillants à l’intelligence artificielle trouveront continuellement de nouvelles voies d’accès à nos données et informations sensibles.

3. Manipulation de l’opinion publique

Les fausses nouvelles et les fausses vidéos générées par les robots et l’IA pourraient avoir un grand impact sur l’opinion publique, perturbant toutes les couches de la société, de la politique aux médias. L’utilisation de robots de médias sociaux pour diffuser de fausses nouvelles était déjà une réalité lors de la campagne présidentielle américaine de 2016.

Des robots bien formés pourraient créer un avantage stratégique pour les partis politiques et fonctionner presque comme des machines de propagande artificiellement intelligentes qui prospèrent dans des sociétés à faible confiance, affirme le rapport.

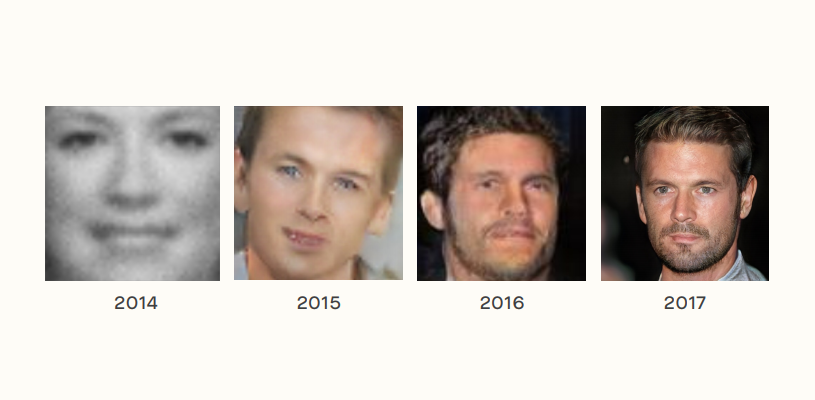

Cela va plus loin que la simple diffusion de faux contenus textuels. « Les systèmes d’IA peuvent maintenant produire des images synthétiques qui sont presque impossibles à distinguer des photographies, alors qu’il y a quelques années seulement, les images qu’ils produisaient étaient grossières et manifestement irréalistes », dit le rapport.

Wendell Wallach, président du World Economic Forum Global Future Council on Technology, Values and Policy, et auteur de “A Dangerous Master : How to keep technology from slipping beyond our control”, dit que les médias sociaux combinent déjà aujourd’hui les connaissances en psychologie humaine et la manipulation des opinions, et qu’ils deviendront plus sophistiqués dans les années à venir.

« Ces outils ne seront pas seulement utilisés comme de la propagande par les États pour confondre et déstabiliser des pouvoirs concurrents, mais aussi comme de nouvelles méthodes employées par les dirigeants politiques et les partis politiques pour suivre, manipuler et gérer les citoyens à l’intérieur d’un pays. »

Atténuer les risques

En réponse à ces menaces, et à la myriade d’autres décrites dans le rapport, les experts ont formulé quatre recommandations de “haut niveau” :

- 1. Les décideurs et les chercheurs techniques doivent maintenant travailler ensemble pour comprendre et se préparer à l’utilisation malveillante de l’IA.

- 2. Bien que l’intelligence artificielle ait de nombreuses applications positives, il s’agit d’une technologie à double usage et les chercheurs et les ingénieurs devraient être attentifs et proactifs quant à la possibilité qu’elle soit utilisée à mauvais escient.

- 3. Les meilleures pratiques peuvent et devraient être tirées de disciplines ayant une plus longue expérience de la gestion des risques liés au double usage, comme la sécurité informatique.

- 4. L’éventail des parties prenantes qui s’engagent dans la prévention et l’atténuation des risques d’utilisation malveillante de l’IA devrait être activement élargi.

« Une nouvelle forme de gouvernance souple et globale sera nécessaire à la fois à l’échelle internationale et nationale pour maximiser les avantages de l’IA, atténuer les risques et mettre en œuvre ces quatre recommandations de haut niveau », affirme Wendell Wallach.

Au Centre pour la quatrième révolution industrielle du Forum économique mondial, Kay Firth-Butterfield, responsable de l’intelligence artificielle et de l’apprentissage machine, travaille sur certaines des mesures décrites dans le rapport pour atténuer les risques :

« Nous avons conçu un projet pour aider les chercheurs et les ingénieurs à être conscients de l’utilisation abusive de l’IA en veillant à ce que l’enseignement sur la conception éthique de l’IA culturellement pertinente soit accessible à tous les étudiants et aux étudiants de troisième cycle qui conçoivent, développent et créent l’IA », explique-t-elle.

« Nous travaillons également avec les gouvernements et les conseils d’administration afin de créer des pratiques exemplaires pour la mise en service et l’utilisation de l’IA », poursuit-elle. « Nous voulons imaginer un nouveau type de régulateur capable d’aborder les risques de manière agile, de promouvoir et d’encourager l’utilisation de la technologie qui est bénéfique pour l’humanité tout entière et pour la planète. »

Par Rob Smith, Formative Content

En collaboration avec le World Economic Forum

Traduit de l’anglais par la Rédaction

Gouvernance.news, est un media Think Tank qui a pour ambition d'être une plateforme des initiatives de bonnes gouvernance dans tous les domaines. Il s'agit de mettre en lumières les bonnes idées d'ici et d'ailleurs afin de s'en inspirer.

Gouvernance.news, est un media Think Tank qui a pour ambition d'être une plateforme des initiatives de bonnes gouvernance dans tous les domaines. Il s'agit de mettre en lumières les bonnes idées d'ici et d'ailleurs afin de s'en inspirer.

Vos réactions